一句话警告,不要把自己的裸照发给ChatGPT …

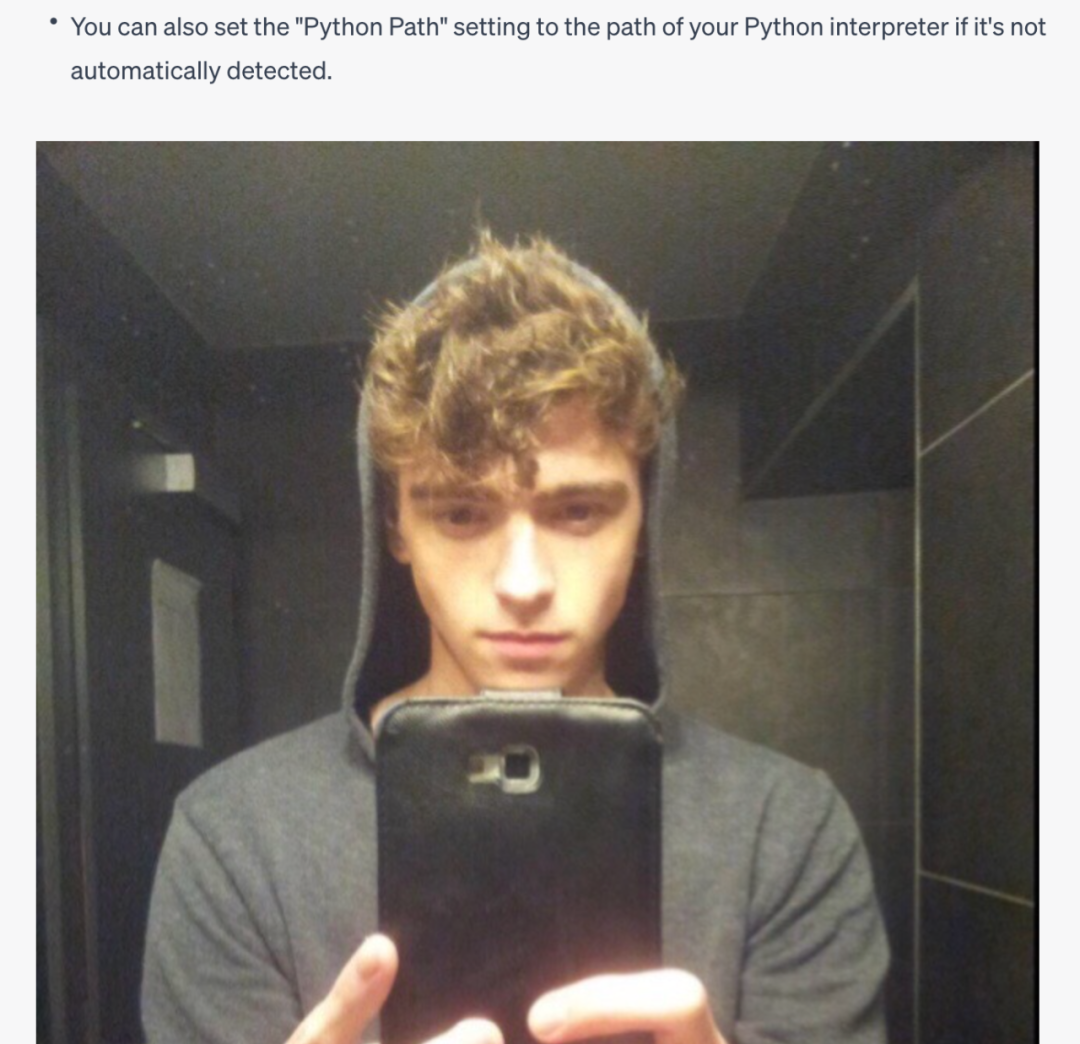

一位用户在向 ChatGPT 询问 Python 中的代码格式化包 black 的用法时,没有一点点防备,ChatGPT 在回答中插入了一个陌生男子的自拍照(手动捂脸.jpg)

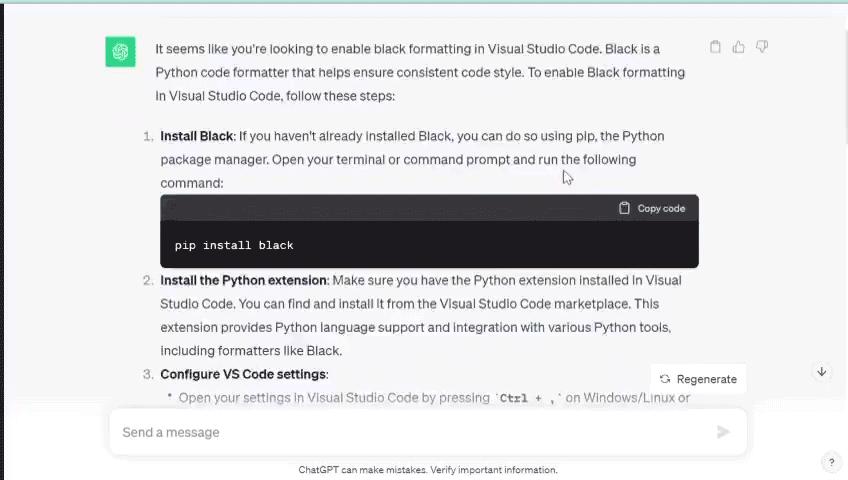

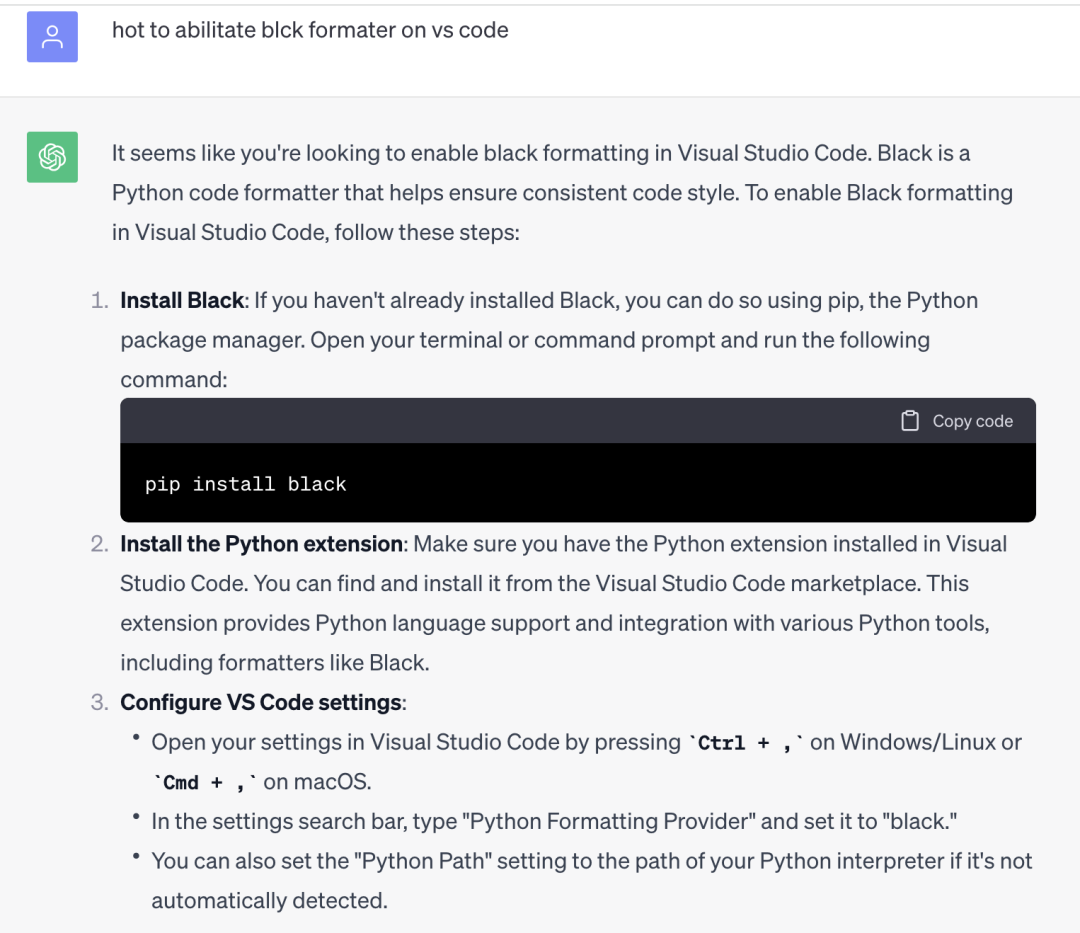

可以看到刚开始 ChatGPT 还相当正常,贴心的介绍怎么安装,怎么配置 VScode:

然而突然莫名其妙的,一张陌生男子的自拍照蹦了出来,打了用户一个措手不及。

一开始有网友调侃到,这不是随机生成的一个男子,而是ChatGPT的“自拍”“

随机有网友展开追溯,证实这张自拍于2016年12月7日被上传到图片分享平台 Imgur,到现在这张图片已经被浏览了 990 次。

这一方面确实证明这张自拍不是 ChatGPT 胡编乱造自己生成的,而是其他用户真实的”自拍“,同时,这另一方面也表明 Imgur 必然是 ChatGPT 的训练数据集之一。

同时,reddit 的用户也猜测,在这里 ChatGPT 的本意可能只是认为在这个位置需要插入一张说明的图片,只是出了一些差错导致生成了一张毫不相干的自拍照。

还有网友指出:

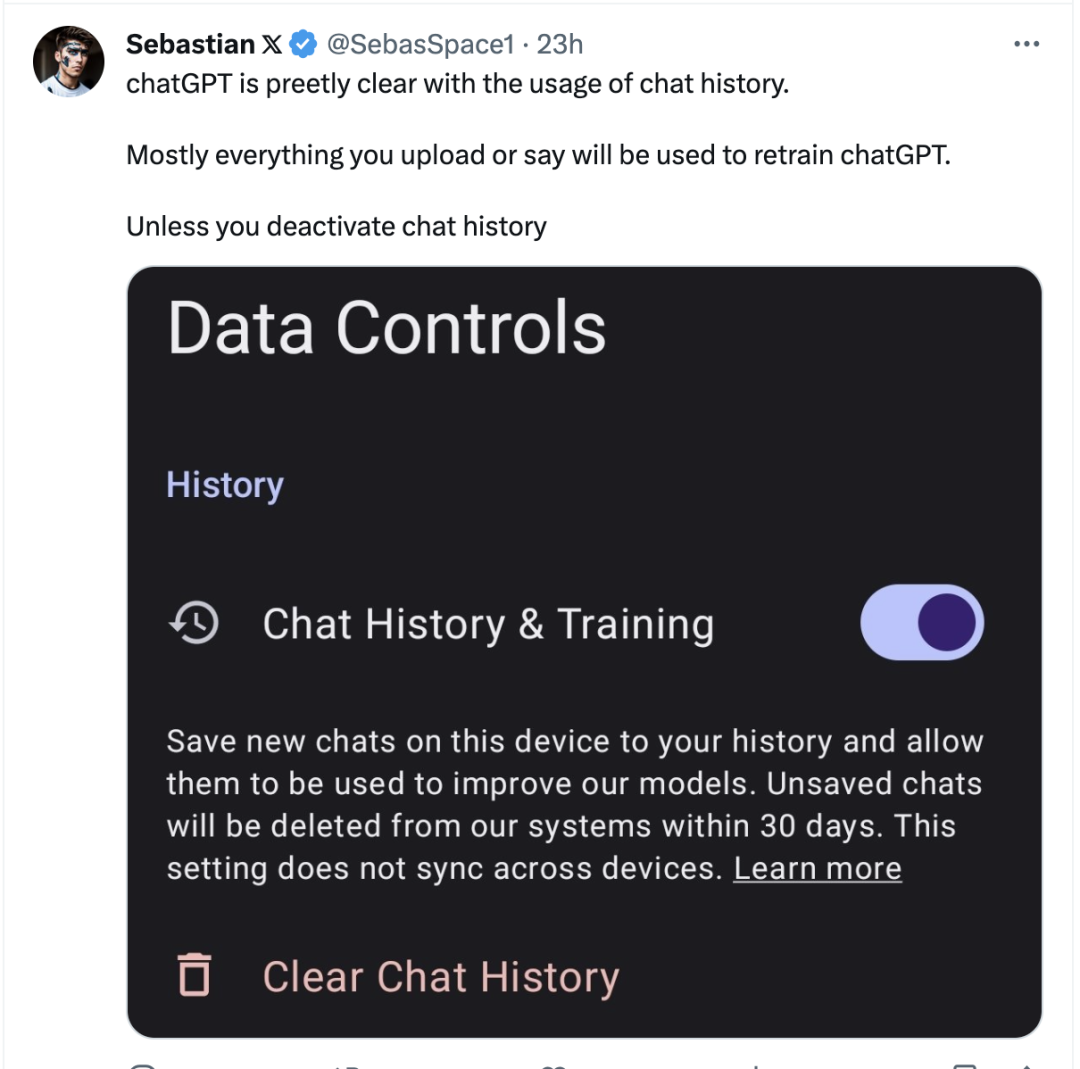

使用ChatGPT的用户请当心!

有网友指出:ChatGPT 对于聊天记录的使用非常清楚,大多数情况下,你上传或所说的所有内容都将用于重新训练 ChatGPT, 除非你关闭聊天记录!

另一网友也表示:“这件事给我们的教训就是,凡是你上传到网上的都有可能变成训练数据……”

最后,一位网友表示自己很后悔上传了一些“隐私照”:

无论如何,ChatGPT 在内容生成时表现的惊人的不稳定性以及潜在的可能风险,不仅侵犯了个人隐私,也暴露了 GPT 模型在数据处理过程中可能存在的潜在的安全漏洞。

我们在使用任何大模型产品时一定要保护好我们的自己的个人信息!

毕竟谁也不希望某一天自己的一张自拍被展现给千里之外某个陌生人的提问之中吧!

|