首先列出观点: 我们必须继续发展人工智能。

人工智能就是新时代的核武器,潘多拉魔盒一旦被打开,就不会有停止。

举个大家最近很热点的隐私窃取为例:当你还在担心手机会不会偷偷录音窃取隐私的时候,已经有人用手机的加速传感器来间接“偷听”你们的说话了。

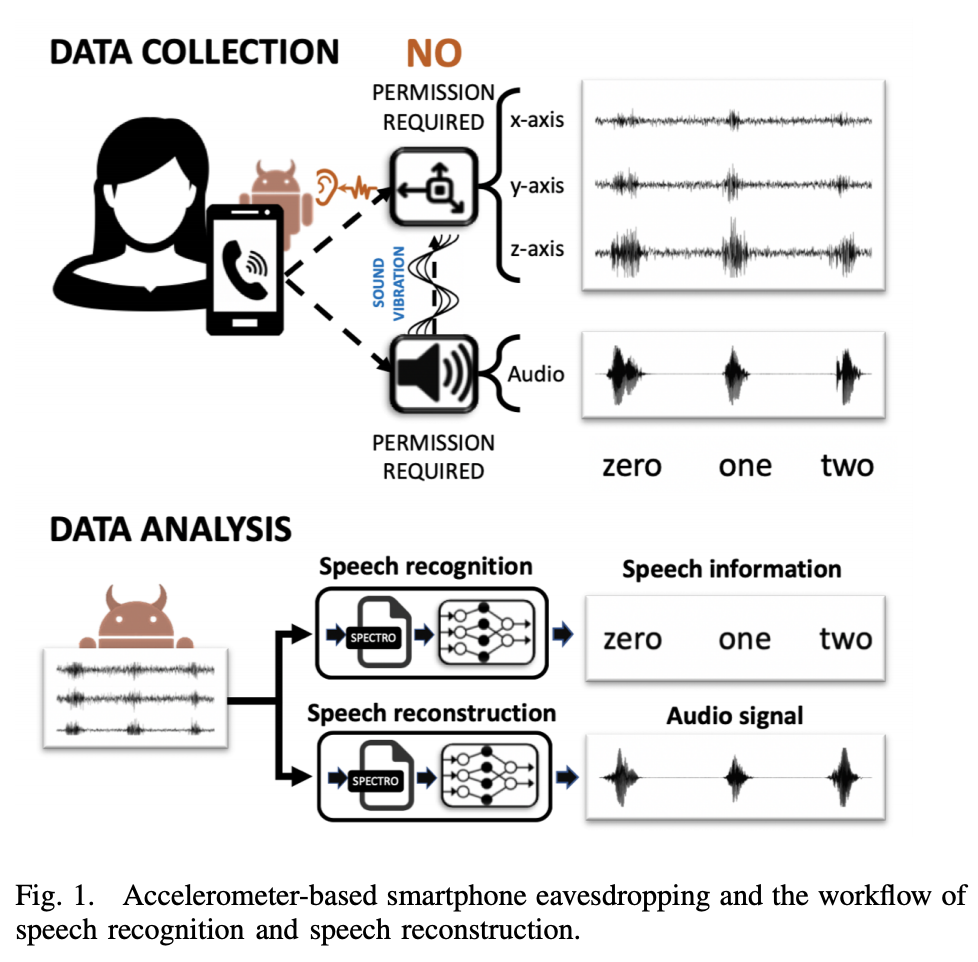

@Ele实验室 《App是不是在监听我们的谈话?》介绍了这种窃取隐私的可行性,通过加速传感器的振动信号,通过深度学习的方式来“预测”你的说话内容。

说话和行动时会产生振动,这些振动信息对应着特定的行为和说话内容。

手机的加速传感器获取三维的时频域振动信息,这种时序预测就是机器学习的强项了。

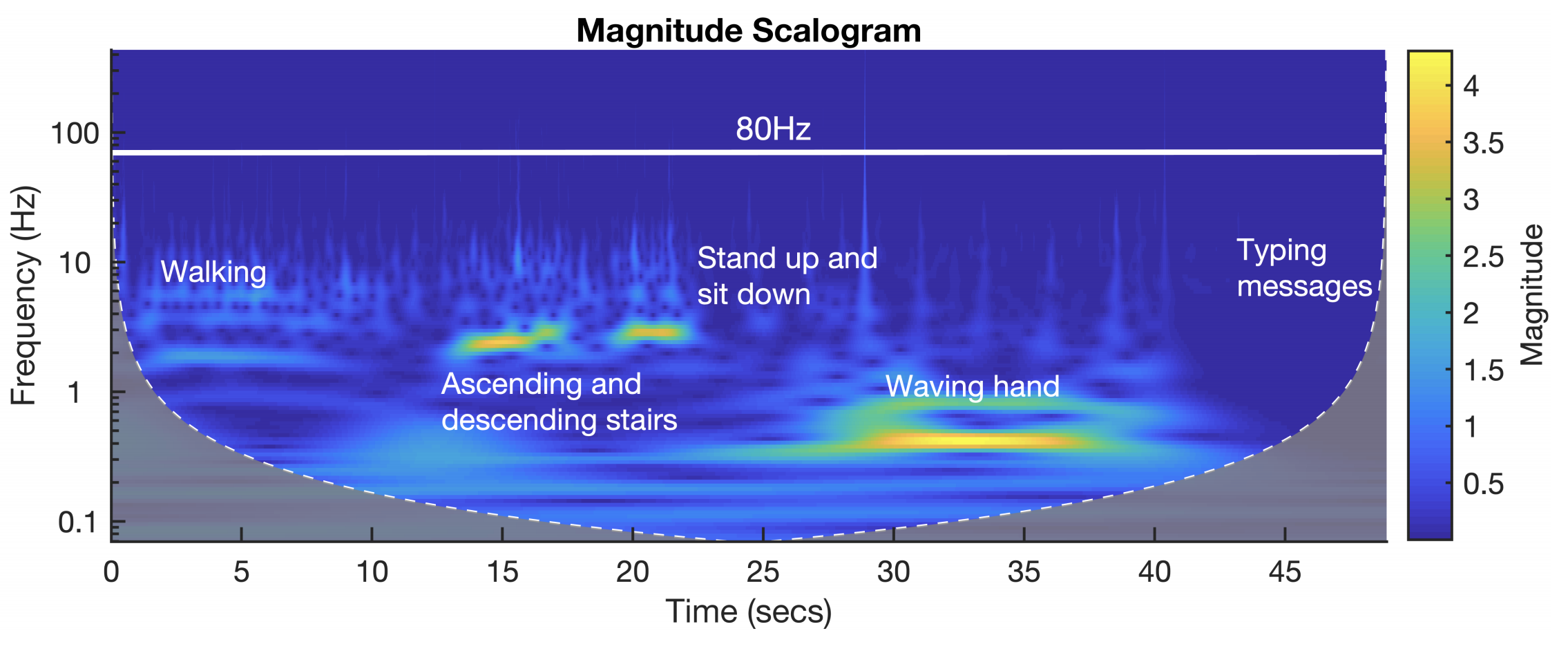

通过振动预测行动

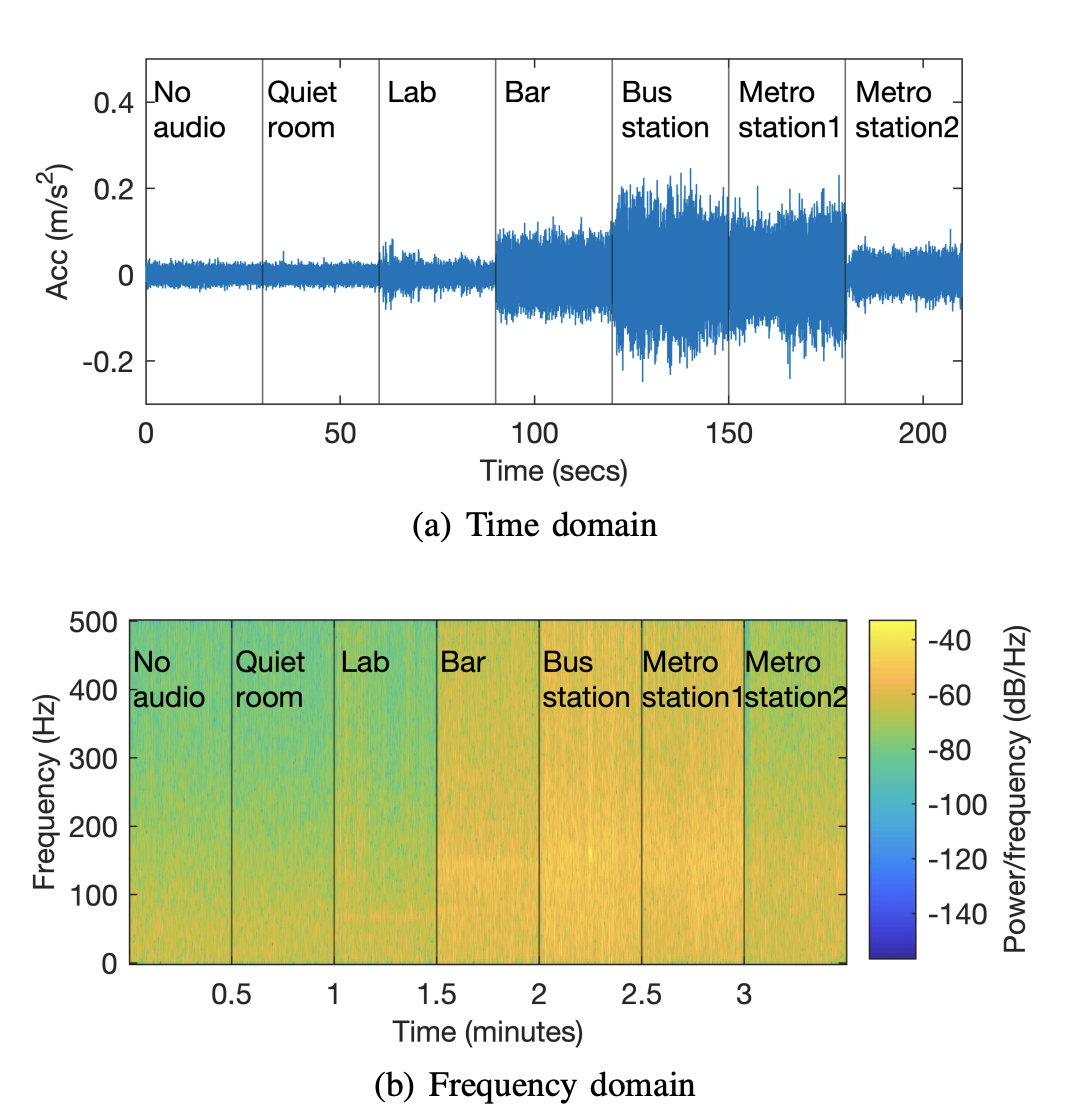

通过背景噪音预测所在场合

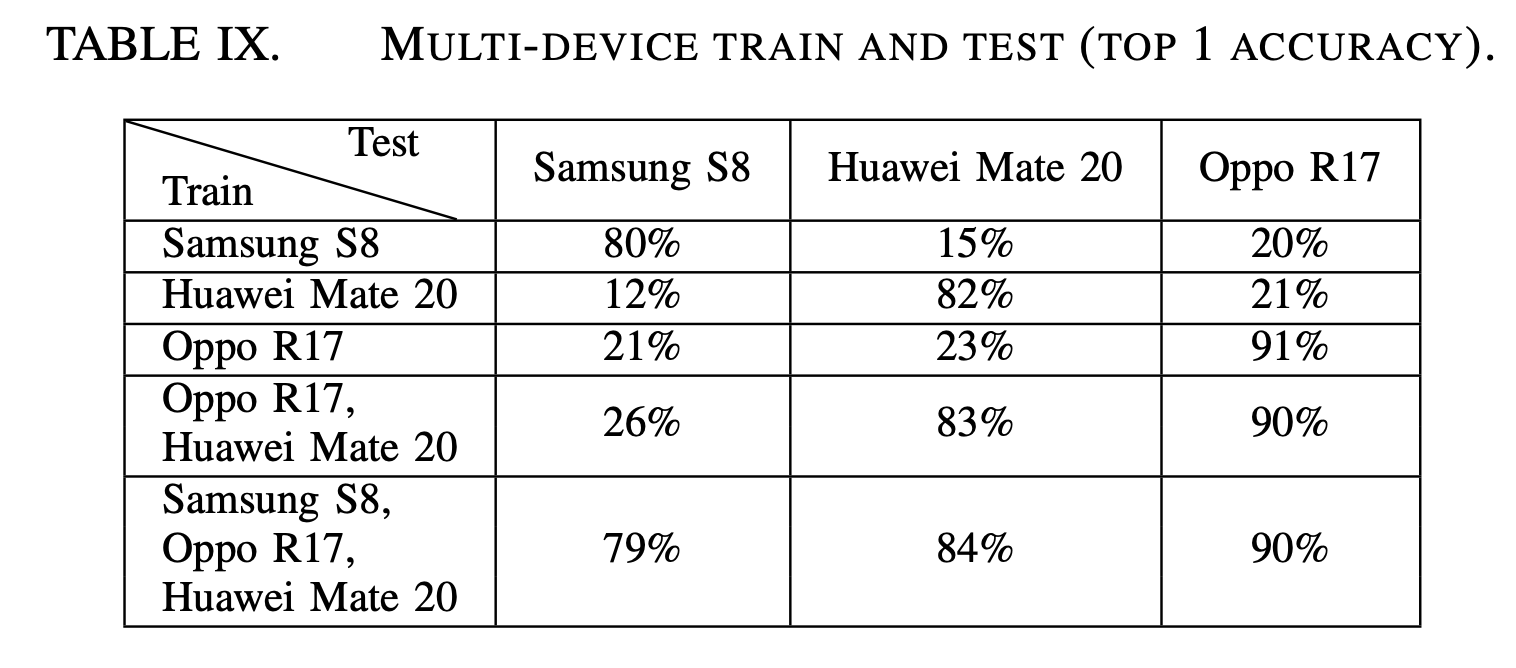

预测的 Top-1 精度

因此,仅提高用户的自我保护意识是不够的,现有技术的发展已经超乎大家认知水平,认为没有录音权限就不会检测到说话内容、没有摄像头启动就没有人脸信息泄露,这些基于常识的内容正在被专业人士破解。

但是,时代的车轮推着人类的认知以及道德法律向前迈进,而科技的进步就是时代车轮的发动机。

让更多的人类更好地活下去,只能依靠科技的不断发展,未来的征途在星辰大海。

曾经我们造出了核武器,认为世界毁灭就系与一线之间,但在均衡中我们以核威慑减少了全面战争的爆发,使得各方能够保持克制;

如今我们发展人工智能的程度还仅处于婴幼儿时期,真正的技术爆炸可能还需要等待下一次理论上的革新。

所以,向前吧!即使新时代没有载着老夫的船,但是请务必前进、前进、前进!

参考文献:Learning-based Practical Smartphone Eavesdropping with Built-in Accelerometer |